Educação (UESC)

Professores da Uesc citados pelo Projeto The Science Archive.

Artigo sobre “Extensão de Operadores de Redes Neurais Simetrizados com Funções de Ativação Fracionária e Mista” foi avaliado

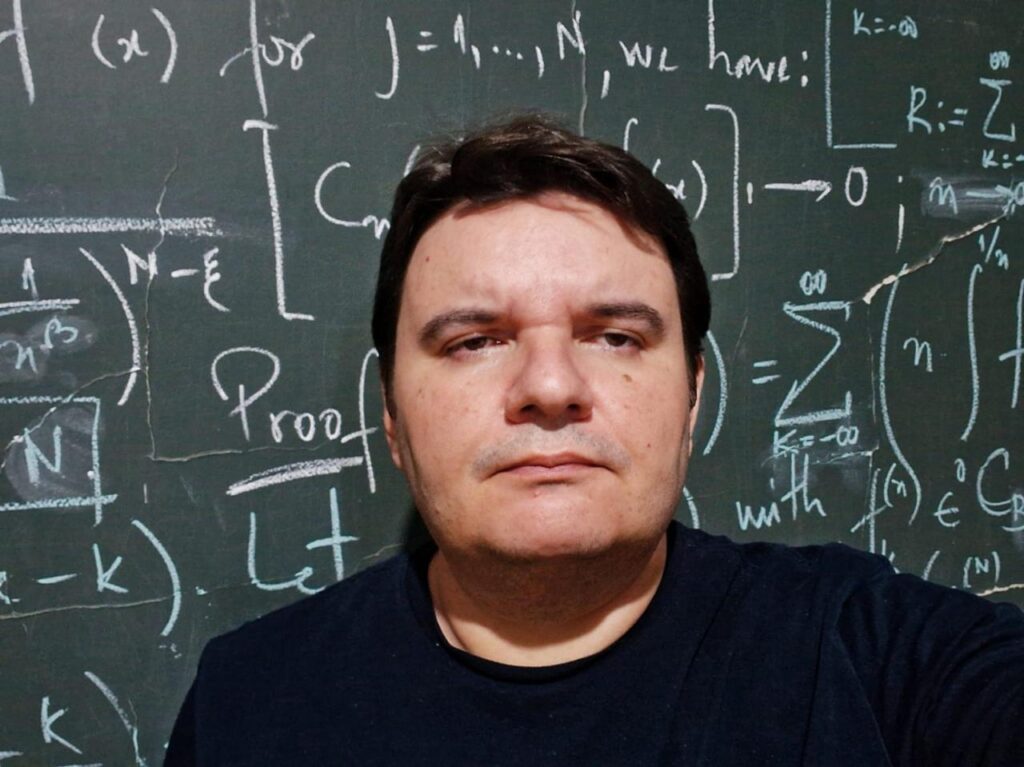

O artigo “Extension of Symmetrized Neural Network Operators with Fractional and Mixed Activation Functions” “Extensão de Operadores de Redes Neurais Simetrizados com Funções de Ativação Fracionária e Mista” (2025) da autoria dos professores doutores Jorge Henrique de Oliveira Sales, (Pleno) e Rômulo Damasclin Chaves dos Santos, (Bolsista Pós Doc Probol PPGMC), sendo o professor Sales supervisor do Pós Doutorado do professor do programa de Pós Graduação em Modelagem Computacional da Universidade Estadual de Santa Cruz (Uesc), foi analisado com destaque na edição do dia 10 de março de 2025 do The Science Archive.

O grupo de pesquisadores do Projeto The Science Archive desenvolve tecnologia de IA para analisar e interpretar as pesquisas mais recentes do arXiv, um repositório de pré-impressão usado pela comunidade científica.

Com o título “Advancing Neural Networks with Fractional Activation Functions”, (Avançando Redes Neurais com Funções de Ativação Fracionária), o The Science Archive destaca que um estudo recente abordou essa limitação introduzindo uma nova extensão para operadores de rede neural simetrizados. A nova estrutura incorpora funções de ativação fracionárias, que permitem aproximações mais adaptativas e precisas de funções complexas.

Para entender como isso funciona, vamos considerar a abordagem tradicional para redes neurais. Essas redes normalmente usam funções de ativação sigmoidal ou ReLU (Rectified Linear Unit), que são limitadas em sua capacidade de capturar padrões sutis e oscilações em dados. As novas funções de ativação fracionária, por outro lado, podem ser adaptadas para melhor se adequarem às características específicas de um determinado problema.

Os pesquisadores por trás deste estudo desenvolveram uma família de funções de densidade que incorporam essas funções de ativação fracionária. Essas funções são projetadas para serem flexíveis e adaptáveis, permitindo que capturem efetivamente padrões e oscilações complexas em dados.

Um benefício fundamental dessa nova estrutura é sua capacidade de lidar com problemas de alta dimensão de forma mais eficaz. Isso é particularmente importante em campos como aprendizado de máquina, onde a complexidade dos dados frequentemente aumenta exponencialmente com o número de recursos ou dimensões.

Outra vantagem das funções de ativação fracionária é sua capacidade de capturar padrões sutis e oscilações em dados. Isso pode ser especialmente útil em aplicações como processamento de sinais, onde pequenas mudanças em amplitude ou frequência podem ter impactos significativos no comportamento geral de um sistema.

Os autores do estudo também desenvolveram desigualdades avançadas do tipo Jackson que fornecem uma base matemática para a nova estrutura. Essas desigualdades estabelecem taxas de convergência uniformes para os operadores propostos, garantindo sua estabilidade e precisão em diversos espaços funcionais.

Embora essa pesquisa ainda esteja em seus estágios iniciais, ela tem o potencial de revolucionar o campo das redes neurais e suas aplicações. Ao fornecer uma abordagem mais flexível e adaptável à aproximação de funções, essas funções de ativação fracionária podem permitir novos avanços em campos como aprendizado de máquina, processamento de sinais e além.

As implicações desta pesquisa são de longo alcance, com aplicações potenciais em áreas como reconhecimento de imagem, processamento de linguagem natural e até mesmo medicina. À medida que nossa compreensão de sistemas complexos continua a evoluir, a necessidade de ferramentas mais sofisticadas e adaptáveis só continuará a crescer.

Acrescentam os pesquisadores do projeto The Science Archive: “Este estudo marca um importante passo à frente no desenvolvimento de redes neurais, oferecendo uma nova abordagem que pode lidar melhor com funções oscilatórias e de alta dimensão”.

Aplicações atuais

O professor Jorge Sales destaca as aplicações atuais sobre:

Resolução de Equações Diferenciais Parciais (EDPs); O framework proposto pode ser utilizado na solução numérica de EDPs, especialmente aquelas que modelam sistemas físicos complexos, como dinâmica dos fluidos e propagação de ondas em meios heterogêneos.

Modelagem de Sistemas Complexos; A flexibilidade das funções de ativação fracionárias pode melhorar a modelagem de sistemas não-lineares, como redes neurais aplicadas à análise de turbulência e escoamentos em meios porosos.

Computação Científica e Engenharia; A capacidade aprimorada de aproximação permite aplicações em otimização de engenharia, como análise estrutural e previsão de falhas em materiais avançados.

Processamento de Sinais e Reconhecimento de Padrões; Pode ser empregado para melhorar o desempenho de algoritmos de filtragem e análise de séries temporais, como em aplicações financeiras e biomédicas.

Referência: Rômulo Damasclin Chaves dos Santos, Jorge Henrique de Oliveira Sales, “Extension of Symmetrized Neural Network Operators with Fractional and Mixed Activation Functions”. (2025

Envie seu comentário